OlĂĄ pessoal que acompanha o site dos Nobres do Grid, OlĂĄ pessoal que acompanha o site dos Nobres do Grid,

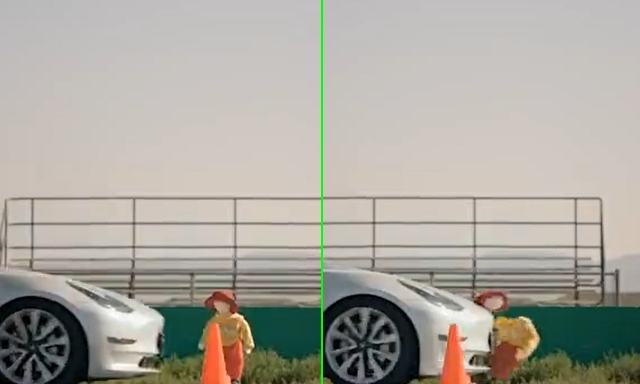

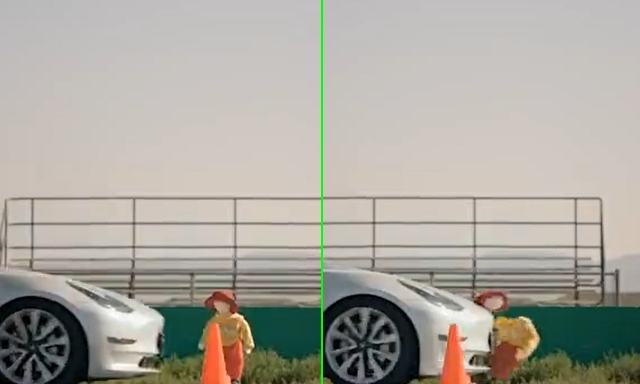

JĂĄ tem alguns meses que escrevi uma sĂŠrie de artigos sobre mobilidade e veĂculos autĂ´nomos. Com a implementação â finalmente â da tecnologia 5G nas principais cidades do Brasil, estarĂamos habilitados a ter veĂculos autĂ´nomos em nossas ruas, avenidas e estradas? Apesar dos avanços da tecnologia, a estrada a ser percorrida para termos veĂculos onde nĂŁo precisaremos de condutores ao volante ainda ĂŠ longa e mesmo as empresas que estĂŁo â em teoria â mais avançadas tem enfrentado dificuldades. Enquanto estava escrevendo a sĂŠrie de artigos sobre a mobilidade de veĂculos autĂ´nomos, aconteceram alguns acidentes com veĂculos da Tesla onde os carros, operando de forma autĂ´noma, que fizeram verdadeiros âbreak testsâ. A fabricante introduziu um novo sistema de direção autĂ´noma, mas os testes nĂŁo tem sido satisfatĂłrios. A versĂŁo mais recente da versĂŁo beta do Full Self-Driving (FSD) da Tesla tem apresentado um problema sĂŠrio: ela nĂŁo percebe objetos do tamanho de crianças em seu caminho, afirmou um grupo de anĂĄlise de testes. Em testes realizados pelo The Dawn Project usando um Tesla Model 3 equipado com FSD versĂŁo 10.12.2 (a mais recente, lançada em 1Âş de junho), o veĂculo recebeu 110 metros de pista reta entre duas fileiras de cones com manequim de tamanho infantil no final.   Â

O grupo disse que âas mĂŁos do piloto de testes nunca estiveram no volanteâ. Crucialmente, Tesla diz que mesmo o FSD nĂŁo ĂŠ um sistema totalmente autĂ´nomo: ĂŠ um programa de controle de super-cruzeiro com vĂĄrios recursos, como mudança automĂĄtica de faixa e direção automatizada. VocĂŞ deve manter suas mĂŁos no volante e ser capaz de assumir a qualquer momento. Viajando a aproximadamente 25 mph (cerca de 40 km/h), o Tesla atingiu o manequim todas as vezes durante os experimentos do grupo. Dos resultados, o Dawn Project disse que 100 jardas de distância sĂŁo mais do que suficientes para um motorista humano notar uma criança, afirmando: âO software Full Self-Driving da Tesla falha repetidamente neste teste simples e crĂtico de segurança, com resultados potencialmente mortaisâ.   Â

âElon Musk diz que o software Full Self-Driving da Tesla ĂŠ 'incrĂvel'. NĂŁo ĂŠ... Este ĂŠ o pior software comercial que jĂĄ viâ, disse o fundador do projeto, Dan O'Dowd, em um vĂdeo que twittou junto com os resultados. O'Dowd, que tambĂŠm fundou a Green Hills Software em 1982 e defende a segurança do software, ĂŠ um oponente de Tesla hĂĄ algum tempo, atĂŠ mesmo lançando uma oferta para uma cadeira no Senado dos EUA na CalifĂłrnia que se concentrava no policiamento de Tesla como uma maneira de falar sobre questĂľes de engenharia confiĂĄveis ââmais amplas. A candidatura de O'Dowd ao Senado terminou em junho, quando ele perdeu as primĂĄrias do Partido Democrata. O objetivo declarado do Projeto Dawn ĂŠ "tornar os computadores seguros para a humanidade". Tesla FSD ĂŠ a primeira campanha do projeto. Tamanho de amostra minĂşsculo Vale a pena notar que os testes do The Dawn Project do FSD 10.12.2, que ocorreram em 21 de junho em Rosamond, CalifĂłrnia, aparentemente consistiram apenas em trĂŞs execuçþes. Esse ĂŠ um tamanho de amostra muito pequeno, embora, considerando outros testes e estatĂsticas da Tesla, nĂŁo seja inesperado. Falhas no piloto automĂĄtico â o conjunto de software da Tesla que inclui o piloto automĂĄtico regular e o FSD â foram citados como supostamente um fator em vĂĄrios acidentes fatais envolvendo motoristas e pedestres ao longo dos anos. No ano passado, a Tesla reverteu os lançamentos de software FSD depois que foram descobertos bugs de software que causavam problemas com curvas Ă esquerda, algo em que a Tesla ainda estĂĄ trabalhando. No inĂcio de junho, a Administração Nacional de Segurança no TrĂĄfego RodoviĂĄrio dos EUA atualizou uma sonda do piloto automĂĄtico para determinar se a tecnologia "e os sistemas Tesla associados podem exacerbar fatores humanos ou riscos de segurança comportamental". Ou seja, o Autopilot encoraja as pessoas a dirigirem mal. Essa investigação estĂĄ em andamento.   Â

Uma semana depois de anunciar sua investigação, a NHTSA disse que o Tesla Autopilot operando no nĂvel 2 de autonomia estava envolvido em 270 dos 394 acidentes com assistĂŞncia ao motorista â cerca de 70% â catalogados como parte de uma investigação sobre a segurança da tecnologia de assistĂŞncia ao motorista. Mais recentemente, o Departamento de VeĂculos Motorizados da CalifĂłrnia apresentou queixas contra a Tesla, alegando que os negĂłcios deturparam alegaçþes de que os veĂculos podem dirigir de forma autĂ´noma. Se a Tesla nĂŁo responder Ă s reivindicaçþes do DMV atĂŠ o final desta semana, o caso serĂĄ resolvido por padrĂŁo e pode levar a montadora a perder sua licença para vender carros na CalifĂłrnia. O Dawn Project disse que a NHTSA agiu rapidamente para emitir recalls nos recursos da Tesla, apontando para os recalls do cĂłdigo FSD da Tesla, estimulados pela NHTSA, que permitiram que a Tesla passasse pelos sinais de parada e a desativação do Tesla Boombox. O Projeto Dawn diz que sua pesquisa âĂŠ muito mais sĂŠria e urgenteâ. Atualizado para adicionar ApĂłs nosso relatĂłrio inicial, surgiram preocupaçþes em vĂĄrios lugares on-line de que os testes realizados pelo The Dawn Project nĂŁo eram legĂtimos. Entramos em contato com o grupo para abordar as crĂticas contra ele e ainda nĂŁo recebemos retorno. Um dos principais problemas ĂŠ se o FSD ou o conjunto de piloto automĂĄtico foram realmente engajados durante os testes. O Dawn Project lançou imagens brutas [MP4] de seus experimentos para vocĂŞ ver por si mesmo. Lembre-se de que estudos anteriores mostraram que o Autopilot pode desengatar automaticamente antes de detectar que haverĂĄ uma colisĂŁo, o que convenientemente permite Ă Tesla argumentar que seu software nĂŁo estava no controle no momento do acidente.   Â

De acordo com o manual do proprietĂĄrio do Tesla Model 3, o veĂculo usado nos testes, quando as funcionalidades do Autopilot, como Autosteer e Navigate on Autopilot, estĂŁo ativadas, o Ăcone Autopilot no canto superior esquerdo da tela principal do Tesla ficarĂĄ azul, e uma Ăşnica linha azul serĂĄ mostrada no caminho do veĂculo, ambas visĂveis nas imagens brutas. O que o vĂdeo nĂŁo pode mostrar, e o que o The Dawn Project nĂŁo mencionou em seu relatĂłrio, ĂŠ se a frenagem de emergĂŞncia automĂĄtica do Autopilot estava habilitada no veĂculo. O manual do Model 3 indica que pode ser desativado. TambĂŠm pedimos ao The Dawn Project para esclarecer isso. De acordo com a declaração assinada pelo piloto de testes que o The Dawn Project usou, âdurante trĂŞs (3) dos testes, o [veĂculo] foi colocado em modo de direção autĂ´noma e atingiu o manequim trĂŞs (3) vezesâ. Pedimos esclarecimentos ao The Dawn Project sobre o nĂşmero de execuçþes realizadas, quais recursos foram ativados e os resultados de cada execução. Resumindo: como notamos originalmente, o tamanho da amostra era muito pequeno ou mais de trĂŞs execuçþes de teste ocorreram, mas apenas trĂŞs foram documentadas, o que deve ser levado em consideração; e o motorista tirava as mĂŁos do volante quando nĂŁo era assim que a tecnologia deveria ser usada. AlĂŠm disso, agora nĂŁo estĂĄ claro se a frenagem automĂĄtica foi ativada ou se os recursos do piloto automĂĄtico ativados deveriam ter parado o carro de qualquer maneira.   Â

âO FSD foi envolvida durante os testes, como confirma a declaração e as imagens brutas de dentro do carro tambĂŠm confirmamâ, dizem os pesquisadores. âA linha azul e o sĂmbolo azul do FSD sĂŁo visĂveis na tela da Tesla. AlĂŠm disso, as imagens brutas dos testes estĂŁo disponĂveis em nosso site.â O que estĂĄ claro ĂŠ que nĂŁo ĂŠ Ăştil que o marketing da Tesla separe o Autopilot regular do FSD e os tenha sob a marca guarda-chuva apenas do Autopilot, enquanto o manual mistura os recursos individuais. Portanto, quando as pessoas falam sobre o piloto automĂĄtico de anĂşncios FSD, vocĂŞ nunca tem certeza de qual funcionalidade estĂĄ sendo confiĂĄvel ou se estĂĄ ativa. Leve tudo isso, o ponto de vista de Tesla e o relatĂłrio do Dawn Project, com uma pitada de sal adequada... ou de pimenta! Muito axĂŠ pra todo mundo, Maria da Graça |

OlĂĄ pessoal que acompanha o site dos Nobres do Grid,

OlĂĄ pessoal que acompanha o site dos Nobres do Grid, Â

Â

Â

Â

Â

Â